Tachyon是一个基于内存的分布式文件系统(项目首页:tachyon-project.org),它是AmpLab的BDAS(berkeley data analytics stack)的一个重要组成。解决了丢失cache导致的重新计算,不同app(job),甚至是不同计算框架间重复的内存使用等问题。目前Spark 1.1默认支持0.5的版本。

Continue reading

Category Archives: Spark

Tachyon的配置和使用入门

Spark as a Service之JobServer项目和命名RDD

JobServer项目

要创建一个JobServer项目,需要下面的流程。

1. 在build.sbt中加入jobserver和spark core的package

|

1 2 3 4 5 |

resolvers += "Job Server Bintray" at "http://dl.bintray.com/spark-jobserver/maven" libraryDependencies += "spark.jobserver" % "job-server-api" % "0.4.0" % "provided" libraryDependencies += "org.apache.spark" % "spark-core_2.10" % "1.1.0" |

Spark as a Service之JobServer部署

续上一篇Spark as a Service之jobServer部署使用开发者模式来测试,本文正式部署并使用jobserver,当前版本有很多BUG和不完善的地方,期待后续的版本修复。

Continue reading

Spark as a Service之JobServer初测

spark-jobserver提供了一个用于提交和管理Apache Spark作业(job)、jar文件和作业上下文(SparkContext)的RESTful接口。该项目位于git(https://github.com/ooyala/spark-jobserver),当前为0.4版本。

特性

“Spark as a Service”: 简单的面向job和context管理的REST接口

通过长期运行的job context支持亚秒级低延时作业(job)

可以通过结束context来停止运行的作业(job)

分割jar上传步骤以提高job的启动

异步和同步的job API,其中同步API对低延时作业非常有效

支持Standalone Spark和Mesos

Job和jar信息通过一个可插拔的DAO接口来持久化

命名RDD以缓存,并可以通过该名称获取RDD。这样可以提高作业间RDD的共享和重用

Continue reading

Spark on YARN

Spark在YARN中有yarn-cluster和yarn-client两种运行模式: Continue reading

Spark Streaming

Spark Streaming基于Spark处理流式数据的框架,在MapReduce中,由于其分布式特性——所有数据需要读写磁盘、启动job耗时较大,难以满足时效性要求。而Streaming能够在Spark上生根发芽的原因是因为其内存特性、低延时的执行引擎和高速的执行效率。

Streaming的原理是将Stream数据分成小的时间间隔(比如几秒),即将其离散化(Discretized)并转换成一个一个数据集(RDD),然后分批处理处理这小的RDD。所以Streaming很容易很mlib,Spark SQL等进行结合,做到实时的数据分析处理。此外,Streaming也继承了RDD的容错特性。如果RDD 的某些 partition 丢失了 , 可以通过 lineage 信息重新计算恢复。

Streaming的数据源主要分下面两类:

· 外部文件系统 , 如 HDFS,Streaming可以监控一个目录中新产生的数据,并及时处理。如果出现fail,可以通过重新读取数据来恢复 , 绝对不会有数据丢失。

· 网络系统:如MQ系统(Kafka、ZeroMQ、Flume等)。Streaming会默认会在两个不同节点加载数据到内存 , 一个节点 fail 了 , 系统可以通过另一个节点的数据重算。假设正在运行 InputReceiver 的节点 fail 了 , 可能会丢失一部分数据。

Continue reading

Continue reading

Spark中的编程模型

1. Spark中的基本概念

在Spark中,有下面的基本概念。

Application:基于Spark的用户程序,包含了一个driver program和集群中多个executor

Driver Program:运行Application的main()函数并创建SparkContext。通常SparkContext代表driver program

Executor:为某Application运行在worker node上的饿一个进程。该进程负责运行Task,并负责将数据存在内存或者磁盘上。每个Application都有自己独立的executors

Cluster Manager: 在集群上获得资源的外部服务(例如 Spark Standalon,Mesos、Yarn)

Worker Node: 集群中任何可运行Application代码的节点

Task:被送到executor上执行的工作单元。

Job:可以被拆分成Task并行计算的工作单元,一般由Spark Action触发的一次执行作业。

Stage:每个Job会被拆分成很多组Task,每组任务被称为stage,也可称TaskSet。该术语可以经常在日志中看打。

RDD:Spark的基本计算单元,通过Scala集合转化、读取数据集生成或者由其他RDD经过算子操作得到。

2. Spark应用框架

客户Spark程序(Driver Program)来操作Spark集群是通过SparkContext对象来进行,SparkContext作为一个操作和调度的总入口,在初始化过程中集群管理器会创建DAGScheduler作业调度和TaskScheduler任务调度。

DAGScheduler作业调度模块是基于Stage的高层调度模块(参考:Spark分析之DAGScheduler),DAG全称 Directed Acyclic Graph,有向无环图。简单的来说,就是一个由顶点和有方向性的边构成的图中,从任意一个顶点出发,没有任何一条路径会将其带回到出发的顶点。它为每个Spark Job计算具有依赖关系的多个Stage任务阶段(通常根据Shuffle来划分Stage,如groupByKey, reduceByKey等涉及到shuffle的transformation就会产生新的stage),然后将每个Stage划分为具体的一组任务,以TaskSets的形式提交给底层的任务调度模块来具体执行。其中,不同stage之前的RDD为宽依赖关系。 TaskScheduler任务调度模块负责具体启动任务,监控和汇报任务运行情况。

创建SparkContext一般要经过下面几个步骤:

a). 导入Spark的类和隐式转换

|

1 2 |

import org.apache.spark.{SparkContext, SparkConf} import org.apache.spark.SparkContext._ |

使用IDEA开发Spark应用

IDEA 全称IntelliJ IDEA,是java语言开发的集成环境,IntelliJ在业界被公认为最好的java开发工具之一,尤其在智能代码助手、代码自动提示、重构、J2EE支持、Ant、JUnit、CVS整合、代码审查、 创新的GUI设计等方面的功能都非常棒,而且IDEA是目前Scala支持最好的IDE。IDEA分ultimate和free edition版,ultimate提供了J2EE等很多非常强力的功能,free edition我觉得已经对于我这样的初学者已经够用了。前面写过一篇配置IntelliJ IDEA 13的SBT和Scala开发环境,本文在这个基础上使用IDEA进行Spark应用的配置和开发。 Continue reading

编译spark-1.0.1源代码

截至到当前为止,spark最新版本为1.0.1。本文测试环境的操作系统是CentOS 7.0 x86_64,jdk为1.7.0_51。编译spark和编译hadoop类似,是一个很简单的过程。

1. 下载spark源代码

|

1 |

wget http://d3kbcqa49mib13.cloudfront.net/spark-1.0.1.tgz |

2. 安装maven或sbt

(1). java-devel是必须要安装的包

|

1 |

yum -y install java-devel |

(2). 安装maven

|

1 |

yum -y install maven |

检查maven

|

1 2 3 4 5 6 7 |

# mvn -v Apache Maven 3.0.5 (Red Hat 3.0.5-16) Maven home: /usr/share/maven Java version: 1.7.0_55, vendor: Oracle Corporation Java home: /usr/lib/jvm/java-1.7.0-openjdk-1.7.0.55-2.4.7.2.el7_0.x86_64/jre Default locale: en_US, platform encoding: UTF-8 OS name: "linux", version: "3.10.0-123.4.2.el7.x86_64", arch: "amd64", family: "unix" |

Git In IDEA

1. 使用命令行来clone branch

安装git之后,使用下面方式来初始化git本地目录

|

1 2 3 4 |

git config --global user.name 'debugo' git config --global user.email 'xiaoluffy@gmail.com' cd <your project home> git init |

clone spark源代码

|

1 |

git clone git://github.com/apache/spark.git |

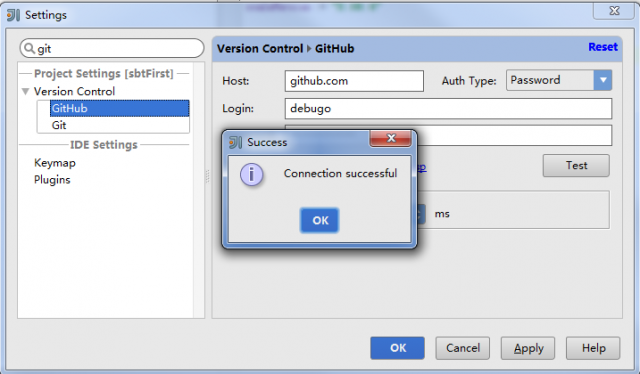

2. IntelliJ配置git

File – Setting – Version Control – Github,配置github account

分享项目Github上:

选择菜单”VCS — Import into Version Control — Share project on Github”

不必输出library,等到分享结束。

Successfully shared project on Github: sbtFirst..

3. 通过IntelliJ来checkout源代码

输入git URL:

git://github.com/apache/spark.git

完成后会提示你是否打开。

^^